【摘要】:每个文档都是XML格式,其基本数据格式为:参数:url:表示网页所在地址,通过这个地址可获取页面链接。表4-1搜狐新闻语料库

1.搜狐新闻数据简介

搜狐新闻数据来自搜狐新闻2012年6月至7月期间有关国内、国际、体育、社会、娱乐等18个频道的新闻数据,提供URL、标题和正文信息,是经过手工整理与分类的新闻语料与对应的分类信息。其中完整版总共有141万多篇文档[1]。

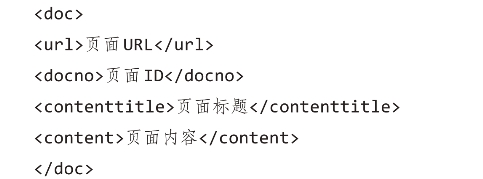

每个文档都是XML格式,其基本数据格式为:

参数:

url:表示网页所在地址,通过这个地址可获取页面链接。

docno:表示页面的ID号。

contenttitle:表示页面内容标题。

content:表示页面的内容,这里的内容是纯文本格式,没有其他的网页页面标签。

例如,其中的一篇公益类的文本文档为:

因此,为了实现文本内容的分析处理,需要对页面内容进行解析,获取每个页面content、url等元素的值即可;但也有类似下面这样的文本文档:

这种只有标题没有实际内容(content内容为空)的文档,或者是内容的字符量太少,会对后续文本分析产生不利影响。因此,对于这种内容比较短小的文本,在后续文本预处理的过程中需要删除。

2.搜狐新闻数据集处理

1)获取文本类别标签

抽取<url>和</url>之间的内容。(https://www.xing528.com)

2)创建类别目录

根据获取的文本文档类别标签,将所有的新闻文本都存储在相应的类别中。

![]()

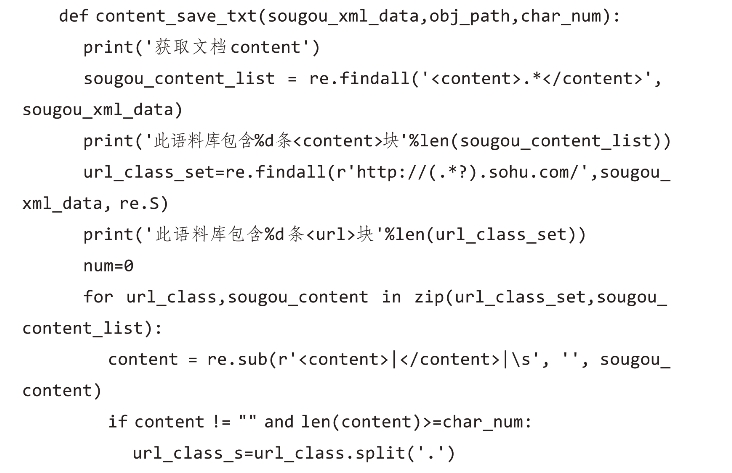

3)获取文本数据

抽取XML文档中的内容数据(<content>标签),然后保存为文本文件(TXT)格式。

4)存储文本数据

按照类别存储原始语料库的文本文档。

经过相关处理后,搜狐新闻语料包含类别见表4-1。

表4-1 搜狐新闻语料库

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。