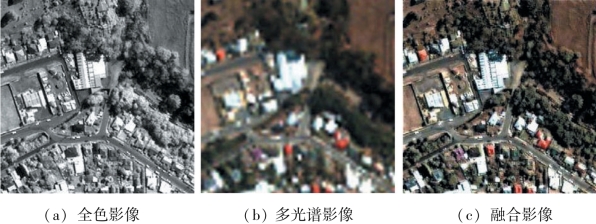

图9-4 基于稀疏表示的城市遥感影像空谱融合结果

目前,在已有的深度学习方法用于遥感图像融合的研究中,大多数学者直接采用了超分辨率重建中的经典网络SRCNN来实验遥感图像的融合。这些方法仅仅采用了三层卷积层的网络结构,无法发挥深度学习最核心的效果来提取更深层次的特征。同时,这些方法将全色图像视为一个额外的波段叠加在多光谱图像上,从而形成网络的输入,这种操作使得两种图像各自的特征被忽略。

在本节介绍的方法中,遥感图像空谱融合的过程与目前经典的方法一致,包含特征的提取与融合两个过程。对于多光谱图像与全色图像,区别于目前其他的基于深度学习的方法,设计了两条线路分别提取它们的特征。整个网络的训练流程如图9-5所示。

图9-5 遥感图像空谱融合网络结构

如图9-5所示,用于提取多光谱图像和全色图像特征的两个支线的网络深度分别为m与p。在支线之中,除了输入以及支线的输出(m或p层),其他层的参数设置保持一致:64个大小为3×3×64的滤波器,每个滤波器将对64个波段(特征图)中的每一个波段进行空间大小为3×3的滤波。每条支线的第一层同样包含64个滤波器,但滤波器的大小为3×3×k,其中k代表输入图像的波段数目。每条支线的输出由32个大小为3×3×64的滤波器构成,从而获得根据输入图像提取出的特征。获得支线的结果后,进入特征的融合阶段,将两条支线的结果特征图按照维度进行拼接,在整个网络的最后一层上设置4个大小为3×3×64的滤波器,以获得与标签维度相同的结果。

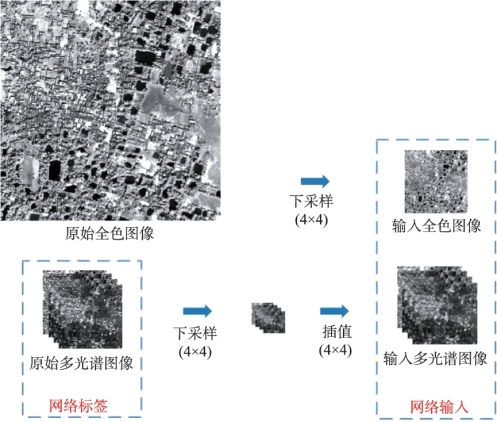

依据Wald's准则,原始多光谱图像将被作为网络的标签。为了和原始多光谱图像保持一致的空间分辨率,原始全色图像需要根据原始多光谱图像与它的空间分辨率的比率进行下采样。与此同时,原始多光谱图像也要进行同样比率的下采样以获得用于输入网络的低空间分辨率多光谱图像,并在此基础之上对这幅图像进行插值,获得与原始多光谱图像同样大小的低空间分辨率多光谱图像。图9-6展示了如何根据以上原则准备训练数据。

图9-6 训练样本准备过程(https://www.xing528.com)

以QuickBird图像为例,依据图9-6进行训练样本准备。原始多光谱图像与全色图像的空间分辨率分别为2.8m与0.7m。网络的输入可以通过对原始多光谱图像和全色图像进行四倍(全色图像与多光谱图像空间分辨率的倍数差异)下采样以获得空间分辨率分别为11.2m与2.8m的多光谱图像与全色图像。因此,这样的操作便将原始的融合任务转变为融合11.2m空间分辨率的多光谱图像与2.8m空间分辨率的全色图像,以获得2.8m空间分辨率的融合后的多光谱图像。此时,这样便存在标签(原始多光谱图像)来训练网络并能够在主观和客观角度上对融合得到的多光谱图像进行评价。

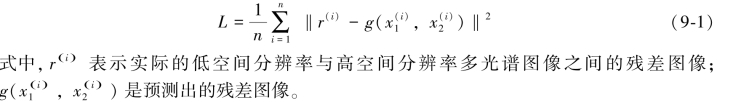

网络训练采取的是残差学习的方法,由于低空间分辨率与高空间分辨率的多光谱图像极为相似,本章定义残差图像r=y-x1来反映它们之间的差别。残差图像应当是稀疏的,即大部分像素的值为0或很小的数值。这种方式可以忽略冗余信息让网络专注于学习能够提升多光谱图像空间分辨率的特征以获得更好的融合结果。因此学习的任务便改为学习一幅残差图像,使得输入的低空间分辨率多光谱图像与残差图像叠加,便能还原出高空间分辨率多光谱图像。此时,损失函数则变为

为了实现残差学习,可以对网络的损失层做一些微小的改动。损失层包含以下几个部分:低空间分辨率多光谱图像,残差图像以及标签(高空间分辨率多光谱图像),而预测的融合结果可以通过前两者的相加获得。然后能够通过以下方式重新将损失函数转化为式(9-2):

通过这种方式,便能继续使用式(9-2)来训练整个网络并达到残差学习的目的。图9-7为基于深度学习的城市遥感影像空谱融合结果。

图9-7 基于深度学习的城市遥感影像空谱融合结果(Shao et al.,2018)

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。