神经网络的发展历史曲折荡漾,既有高潮,也有低谷。从单层神经网络(感知器)开始,到包含一个隐藏层的两层神经网络,再到多层的深度神经网络,一共有三次兴起过程,如图7-1所示。

图7-1 三起三落的神经网络

最早的神经网络数学模型由Warren McCulloch教授和Walter Pitts教授于1943年提出。[1]论文中提出了一种模拟大脑神经元的结构——莫克罗-彼特氏神经模型,结构如图7-2所示。

图7-2 莫克罗-彼特氏神经网络模型

直到现在我们也不完全清楚人类神经元处理信号的原理,所以莫克罗-彼特氏神经网络模型采用的是线性加权的方式模拟这个过程,其中I为输入,w为权重,输入乘以权重然后相加,最后经过一个阈值函数后作为输出。所以,这个模型性能的好坏完全由分配的权重决定,另外莫克罗-彼特氏神经模型手动分配权重的方式既麻烦又很难达到最优分类效果。

为了让计算机能够更加自动且更加合理地设置权重,Frank Rosenblatt教授于1958年提出了感知机模型,或者叫感知器模型。感知机是使用特征向量来表示的前馈式人工神经网络,它是一种二元分类器,在人工神经网络领域中,感知机也被称为单层人工神经网络。1969年,Marvin Minsky和Seymour Papert在“Perceptrons”一书中,仔细分析了以感知机为代表的单层神经网络系统的功能及局限,证明感知机不能解决简单的异或等线性不可分问题[2],Marvin Minsky教授甚至得出了“基于感知机的研究注定失败” 的结论。

由于Rosenblatt教授等没能够及时将感知机学习算法推广到多层神经网络上,以及“Perceptrons”在研究领域中的巨大影响,人们对书中论点的误解造成了人工神经领域发展的长年停滞及低潮,之后的十多年内,基于神经网络的研究几乎处于停滞状态。直到人们认识到多层感知机能够弥补单层感知机固有的缺陷,在20世纪80年代BP算法提出后,基于神经网络的研究才有所恢复。1987年,书中的错误得到校正,并更名再版为“Perceptrons-Expanded Edition”[3]。这是神经网络发展的第二个阶段。(https://www.xing528.com)

20世纪80年代末,神经网络的研究再次兴起,这源于分布式表达与反向传播算法的提出。分布式知识表达的核心思想是现实世界中的知识和概念应该通过多个神经元来表达。分布式表达大大加强了模型的表达能力,解决了类似异或这种线性不可分的问题。

除了分布式表达,David Everett Rumelhart教授等于1986年在《自然》杂志上首次提出了著名的反向传播算法(BackPropagation,BP),此算法大幅降低了模型训练所需要的时间。直到今天,BP算法仍然是训练神经网络的主要算法。同时,计算机的飞速发展也使得计算机有了更强的计算能力,这些因素使得神经网络在20世纪80年代末到90年代初又迎来了发展的高峰期。

在神经网络发展的同时,传统的机器学习算法也取得了突破性的进展,SVM算法具有理论基础完整、样本量少等优点。同时由于BP算法针对深层网络存在梯度消失、数据量太小无法支撑深层网络训练等问题,刚刚兴起的神经网络被支持向量机所取代。

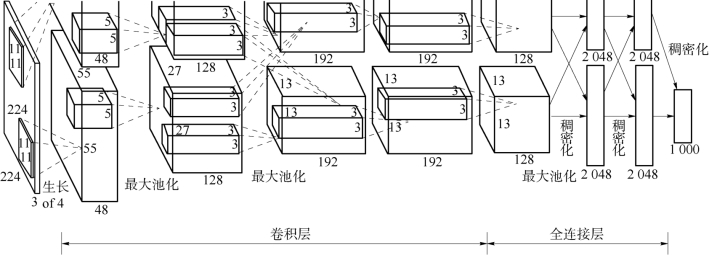

进入21世纪,计算机性能进一步提高,图形处理器(Graphics Processing Unit,GPU)加速技术出现,计算量不再是阻碍神经网络发展的问题。与此同时,随着互联网的发展,获取海量数据不再像20世纪末那么困难,这为神经网络再次发展提供了条件。值得一提的是ImageNet项目的建立,美国斯坦福大学的李飞飞教授开启了视觉基因组计划,把语义和图像结合起来,缔造了当前世界上最大的图像数据库——ImageNet。这个庞大的数据库由来自世界上167个国家的接近5万个工作者完成,ImageNet的出现使所有人都能够轻松地获取足以支撑其深度网络训练的数据。同时,斯坦福大学每年都会举行一个比赛,邀请谷歌、微软、百度等IT企业使用ImageNet数据库,而第一个应用深度神经网络的算法AlexNet,就是ImageNet竞赛2012年冠军,这个著名的网络结构如图7-3所示。

图7-3 AlexNet模型

AlexNet取得的突破性进展使得神经网络的研究再一次达到高峰,随后其他关于深度神经网络(Deep Neural Networks,DNN)的更复杂的结构也陆续出现,并在除了计算机视觉外的诸多领域中取得了优异的成绩,如语音识别、自然语言处理等。2016年,谷歌公司的AlphaGo战胜了李世石,深度学习作为深层神经网络的代名词,被各行各业的人所熟知。深度学习的发展也开启了一个人工智能的新时代。

最后需要指出的一点是,虽然深度学习领域的研究人员相比于其他机器学习领域更多地受到大脑工作原理的启发,但是现代深度学习的发展已经不完全是模拟人脑神经元的工作过程,或者说目前人类对大脑的工作机制的认知还不足以指导当下的深度学习模型[4]。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。