两个随机变量X和Y,当知道Y时,X的平均不确定性是多少?这个平均不确定性称为条件熵(Conditional Entropy)。和熵的概念类似,只不过将概率空间及分布换成了条件概率对应的空间及分布,详细内容参见本书附录B。请大家各自回顾我们讲条件概率时,如何确定条件概率对应的概率空间。

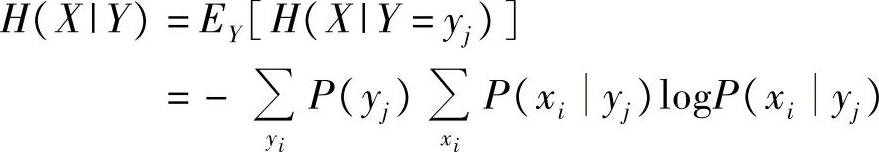

定义9-2(条件熵) 两个随机变量X和Y,当知道Y时,X的平均不确定性称为条件熵H(X|Y),并且

根据联合熵和条件熵的定义知:

性质9-3 熵、联合熵、条件熵满足如下关系:

H(X,Y)=H(X)+H(Y|X)(9-16)

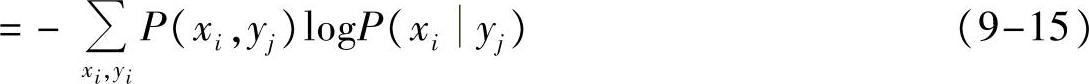

两个随机变量X和Y,考察X。假设发射端打算告诉接收端一个满足X分布的无穷长序列,当发射端还没有把这个序列发给接收端时,即接收端什么信息都没有时,H(X)反映了接收端不能判断发射端打算发的是哪一个序列的序列个数;而当发射端把这个序列发给接收端后,接收端得到了Y,即接收端得到了一部分信息,虽然有多个X序列可能都会得到Y,从而仍然不知道具体X是哪一个。但是,多多少少会明确知道哪些X一定不是发射端发的序列,即一定得不到Y的X。这里H(X|Y)反映了接收端在知道Y时仍然不能判断发射端发的是哪一个序列的序列个数,也即反映了能得到Y序列的X序列的平均个数。这样,按照平均不确定性的理解,不确定的序列个数减少了,从而一定程度上获得了信息量,即减少的那一部分不确定性

H(X)-H(X|Y)(9-17)

这个信息量也被称为互信息。

X序列和Y序列的对应关系如图9-2所示。

(https://www.xing528.com)

(https://www.xing528.com)

图9-2 X序列和Y序列的对应关系

定义9-3(互信息) 两个随机变量X和

Y,当知道其中一个,从而得到的关于另一个的信息量被称为互信息I(X;Y)

I(X;Y)=H(X)-H(X|Y)=H(Y)-H(Y|X)(9-18)

互信息的概念也可以有向量形式和条件互信息。比如互信息的向量形式推广

I([X1,X2];Y)=H(X1,X2)-H([X1,X2]|Y)(9-19)

表示一对随机变量(随机向量)和一个随机变量之间,知道其中一方能获得的关于另一方的信息量。又比如条件互信息

I([X;Y]|Z)=H(X|Z)-H(X|[Y,Z])(9-20)

表示在已经知道Z的情况下,知道Y能获得的关于X的信息量,等于在知道Z时X的平均不确定性与同时知道Z和Y时X的平均不确定性的差值。并且互信息满足如下链式法则:

I([X1,X2];Y)=I(X1;Y)+I([X2;Y]|X1)(9-21)

表示一对随机变量(随机向量)[X1,X2]和一个随机变量Y之间,知道Y能获得的关于[X1,X2]的信息量等于知道Y能获得的关于其中一个分量(比如X1)的信息量与在该分量X1已知条件下知道Y能获得的关于其中另一个分量(比如X2)的信息量之和。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。