【摘要】:在Spark1.3版本中,Spark SQL不再是Alpha版本,除了提供更好的SQL标准兼容之外,还引进了新的组件DataFrame。同时,Spark SQL数据源API也实现了与新组件Dat-aFrame的交互,允许用户直接通过Hive表、Parquet文件以及一些其他数据源生成Dat-aFrame。Spark SQL所有功能的入口点是SQLContext,或它的一个子类。只需要一个SparkContext实例就可以构建一个基本的SQLContext。

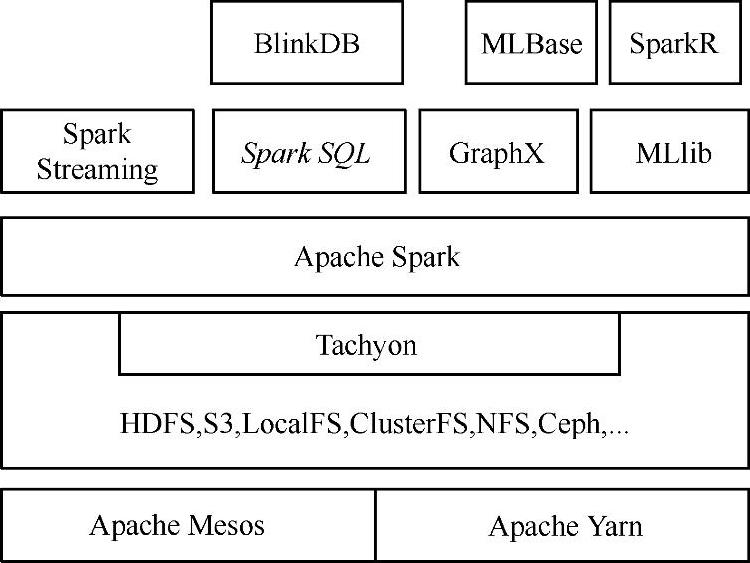

Spark SQL在伯克利数据分析协议栈中的位置如图3.1所示:

图3.1 伯克利数据分析协议栈

Spark SQL在Spark内核基础上提供了对结构化数据的处理,在Spark1.3版本中,Spark SQL不仅可以作为分布式的SQL查询引擎,还引入了新的DataFrame编程模型。(https://www.xing528.com)

在Spark1.3版本中,Spark SQL不再是Alpha版本,除了提供更好的SQL标准兼容之外,还引进了新的组件DataFrame。同时,Spark SQL数据源API也实现了与新组件Dat-aFrame的交互,允许用户直接通过Hive表、Parquet文件以及一些其他数据源生成Dat-aFrame。用户可以在同一个数据集上混合使用SQL和DataFrame操作符。新版本还提供了从JDBC读写表的能力,可以更原生地支持Postgres、MySQL及其他RDBMS系统。

Spark SQL所有功能的入口点是SQLContext,或它的一个子类。只需要一个SparkContext实例就可以构建一个基本的SQLContext。

再次强调,spark-shell除了帮我们构建了SQLContext实例外,还帮我们导入了隐式转换:import sqlContext.implicits._。在以spark-submit方式提交的应用程序中,需要手动导入该隐式转换才能访问某些API。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。