ERU研究项目全称是电子资源使用统计分析和访问监控项目(Electric Resource Utilities,简称“ERU”),旨在发现一种可以避开不同数据库厂商的数据库平台的应用异构和数据库异构问题,通过对网络传输底层的电子资源数据包的捕捉和重新封装建模,弥补传统服务器日志分析数据很难获取和数据不完整问题,通过对用户Web访问页面进行页面仿真建模分析,可以实现基于“访问内容级”的统计分析和建模,深层次获取图书馆知识发现和学科服务所需的数据集。同时可以实现图书馆电子资源使用统计按照COUNTER规范进行统计分析和对恶意下载行为的实时监控。

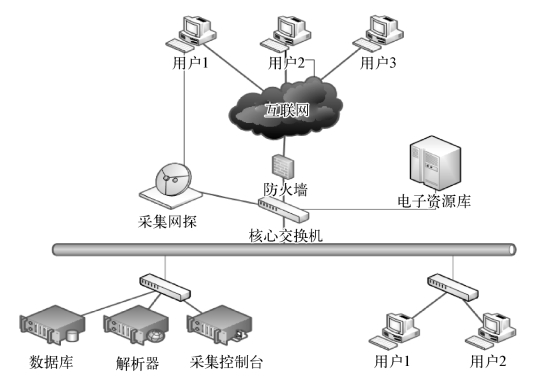

ERU数据采集通过网探硬件和网络出口核心交换机镜像口旁路连接,采用数据流建模技术,基于网络底层采集原始数据再拼接还原,整个过程需要逐步将网络的高速背景流量(峰值速率为1 000 Mb/s级)过滤为纯电子资源访问的低速流量(峰值速率为50 Mb/s级),然后通过识别有效网页(峰值速率为10 Mb/s级)提取有意义的文本信息(128 kb/s或更低)进行建模,最终变为数据库标准记录(50条/s级),其网络部署拓扑图如图2-1所示,在同一网段中,采集网探连接到有电子资源数据库的核心交换机上,对核心交换机的底层网络通信进行全面采集。

图2-1 ERU数据采集原理图

数据采集器和采集控制台,可以实施IP过滤,配置各个需要采集的数据库的地址及URL,获得相应的访问数据,采集控制台将采集到的数据存入数据库。

解析器对图书馆购买的所有电子资源数据库的检索(单库和跨库)、浏览和下载的HTML(超文本标记语言)数据进行解析,可以通过模板定制工具对解析模板进行配置,不同的数据库需要提供不同的模板,并对主要字段根据采集数据的不同类型进行映射。目前针对学位论文、期刊论文、会议论文、图书、标准、专利等进行了元数据的方案设计和映射,对采集的数据能够正确解析还原。

ERU数据采集处理流程主要包括四个阶段:网络采集、数据处理、页面解析、规范入库。数据采集过程见图2-2。

图2-2 网络采集处理流程图

(1)网络采集。(https://www.xing528.com)

网络采集基于核心交换机镜像端口过滤采集原始流量数据,可配置各个需要采集的数据库的地址及URL,获得相应的访问数据,并将其重新组装拼接,还原为可识别的HTML源文件,这些数据最终存入原始HTML数据库。

网络采集阶段考虑的技术要点为数据的高速处理和安全性,通过旁路接入和快速筛选来实现。设备通过旁路方式连接网络交换机的镜像口,如审计设备、监控设备等。设备通过串行方式连接在源和目标之间,如防火墙、接入网关、流量控制设备等。

网络采集通过源IP地址、目的IP地址的黑白名单设置对所有的IP包进行快速筛选,不采集不在名单中的IP包。

(2)数据处理。

数据处理阶段主要考虑的技术要点为协议分析,主要解决技术为内存计算和特征判断,通过分析HTTP(超文本传输协议)、HTTPS(基于安全套接层的超文本传输协议)、FTP(文件传输协议)等协议类型,并通过特征分析技术从URL链接中抽取特征值,确定链接是属于页头、页尾、图片、动画、广告、主体内容等。对于不需要的内容不作处理,仅保留有效网页。

(3)页面解析。

从数据库提取原始HTML数据(图书馆购买的所有电子资源数据库的检索、浏览和下载的HTML数据),开多事务队列,按照既定的解析模板对HTML页面进行解析,去除不必要的JS脚本、CSS(层叠样式表)布局等。

页面解析主要考虑多种格式的模板:混合脚本语言、HTML语言、混合CSS风格标识。预先提取网页特征定义;采用模板化技术包括模板定义、模板应用、模板解析框架的完整内容体系。保持程序主体架构的稳定性,快速、灵活适应多种网页格式。

(4)规范入库。

规范入库主要依据建立的不同资源类型的元数据规范,涵盖题名、主要责任者、主题、描述、日期、格式、标识符、语种等;后根据元数据规范统一建立数据库模型;把网页上解析到的字段内容和元数据规范进行映射。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。