利用深度学习对图像数据和VTS轨迹数据进行数据融合,可以增强当前的VTS功能,生成一个独特的视图,其中来自摄像机和VTS轨迹的信息合并在一起。本节使用了一种分布式跟踪方法,能够融合来自多个异构和非同步源的数据。输入观测由视觉监测模块提供。[46]

视觉监测模块是视频处理单元的一部分,其目的是寻找当前输入图像中感兴趣的对象。由于监测精度影响到VPU流程中的所有阶段,因此必须尽可能高,同时保持可接受的计算负载。VPU的三个主要组件,即HAAR分类器、水平线监测器和噪声滤波器,如图20.6所示。

图20.6 视频处理单元。监测基于HAAR分类器

利用多个传感器跟踪多个物体的问题可以表述如下。设O={o1,…,on}为所有运动物体的集合,每个运动物体具有不同的标识,S={s1,…,sS}为所有传感器的集合,每个传感器都具有相关的FOV,通常只覆盖场景的有限区域。将要观察的对象总数n未知,并且场景中当前对象的数量l(0≤l≤n)可以随时间变化。关于传感器s∈S在一个时间t的FOV中物体的测量(观察)集由![]() 表示,其中测量

表示,其中测量 可以是实际物体,也可以是假阳性。所有传感器在时间t时收集的所有测量值的集合用zS,t={zs,t|s∈S}表示。

可以是实际物体,也可以是假阳性。所有传感器在时间t时收集的所有测量值的集合用zS,t={zs,t|s∈S}表示。

来自传感器的所有测量的时间历史定义为zS,1∶t={zS,j∶1≤|j|≤t}。由于传感器具有不同的刷新率,因此本章不假设传感器生成的测量值是同步的。

目标是以分布式方式(即利用所有可用的传感器)确定场景中所有对象在时间t的位置![]() 的估计值。

的估计值。

为了实现这一目标,可能的解决方案是使用贝叶斯递归方法,定义如下:

![]()

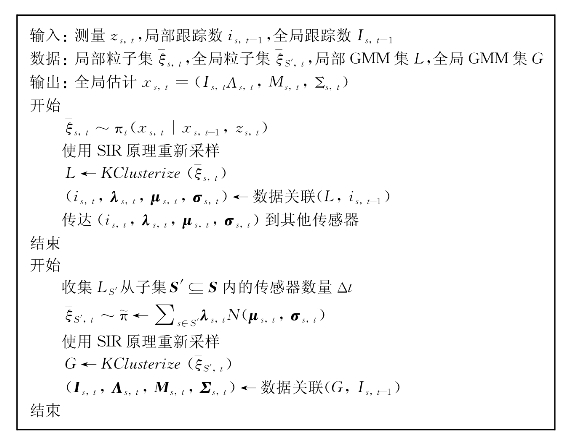

式(20.1)和式(20.2)表示一个全局递归更新,只有在完全了解场景的情况下才可以计算该更新。由于情况并非如此,该章采用基于分布式粒子滤波器的算法来近似上述精确的最佳贝叶斯计算。特别是,本章将ptracking方法(图20.7)扩展到多传感器场景,这是一种基于分布式多簇粒子滤波的开源跟踪算法。

图20.7 ptracking算法

位置xs,t的估计由向量Is,t,Λs,t,Ms,t,Σs,t给出,其中包含关于每个物体的特征(i)、重量(Λ)、平均值(m)和标准偏差(Σ)的信息,表示为高斯混合模型(gmm)。跟踪算法执行期间,矢量的大小可能会有所不同,这取决于监测到的对象的数量。

图20.8 kclusterize算法

估计过程由四个主要步骤组成:①预测步骤,该步骤根据传感器提供的观测zs、t计算估计的演化;②聚类步骤,该步骤将确定其gmms参数的估计分组;③数据关联步骤,该步骤计算估计的演化xs,t;④数据关联步骤,通过考虑所有现有轨迹的历史,将每个观测值分配给现有轨迹。

预测:粒子过滤器使用基于过渡状态模型的初始猜测分布。然后,使用先前的状态xs,t-1,应用由测量zs,t给出的过渡模型。根据这一推测分布,利用当前观测值zs,t,提取一组样本并进行加权。

聚类:一种新的聚类算法,称为kclusterize(图20.8),用于聚类阶段。kclusterize是为满足以下要求而设计的:①要监测的对象数量不是预先知道的;②实时应用需要较低的计算负载;③每个集群都有一个高斯分布。首先,粒子被分组成簇。然后,应用验证步骤来验证每个集群实际上代表一个高斯分布。所有非高斯星团(如果可能)在高斯星团中被分割。最后,得到的簇形成一个GMM集(λs,t,μs,t,σs,t),表示传感器s在t时刻的估计。

与其他聚类方法(如k-均值、em、bsas或qt聚类)不同,kclusterize不需要预先知道聚类数量,具有线性复杂性,所有获得的聚类都反映高斯分布。

数据关联:必须通过将新的观察结果关联到现有的轨迹,为每个对象分配一个标识(即轨迹编号)。这是任何跟踪算法的关键步骤:对象的方向、速度和位置是关联算法所涉及的特征(图20.9)。如果两个运动轨迹之间的夹角小于10°,本文考虑两个方向相同的运动轨迹对象。

图20.9 数据关联算法

数据关联步骤因完全和部分封闭而更加复杂,当船只相对于摄像机视图对齐或彼此靠近时,可能会发生这种情况。本章的解决方案是将崩溃的轨迹视为一组,而不是单独跟踪它们(图20.10)。当两个或多个轨迹的边界框彼此靠近时(图20.10a),跟踪器会保存它们的颜色柱状图,并开始将它们视为一组(图20.10b和图20.10c)柱状图用作遮挡阶段结束时重新识别对象的模型(图20.10d)考虑到估计的轨道和探测器的观测结果,一个小组的发展。当被遮挡对象再次可见时,存储的柱状图用于重新分配正确的标识号,该标识号属于相应的以前注册的轨迹。

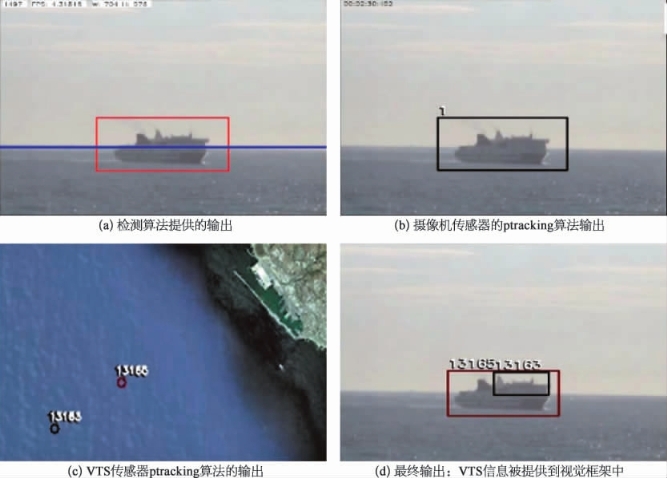

数据融合:如上所述,来自摄像头和VTS系统的信息被融合,以生成被跟踪船只的增强和可靠的状态。数据融合阶段由于缺乏通用的参考帧而变得复杂:事实上,相机的校准参数通常不可用。为了解决这个问题,本章使用了以下算法。以 为摄像机参考帧C中的船i的速度矢量,以VR为VTS参考帧R中船的速度矢量集,通过对每个

为摄像机参考帧C中的船i的速度矢量,以VR为VTS参考帧R中船的速度矢量集,通过对每个 ∈VR的计算,选择了虚拟现实中与摄像机参考帧中船i融合的最佳匹配候选(https://www.xing528.com)

∈VR的计算,选择了虚拟现实中与摄像机参考帧中船i融合的最佳匹配候选(https://www.xing528.com)

图20.10 组跟踪闭塞通过考虑塌陷轨道形成

其中,摄像机和VTS参考帧之间的旋转参数θ通过策略梯度算法计算。更具体地说,优化过程从预先定义的初始值开始寻找θ的最佳值(本章在实验中使用θ=15%)。然后,使用指定给θ的初始值作为摄像机和VTS帧之间的旋转参数进行跟踪和数据融合,以获得定量结果。

然后,并行执行两个计算,分别使用较低和较大的θ值。当计算完成后,重新计算定量结果,检查性能的改善方向。本章将这个新值设置为“初始值”,然后执行算法,直到用于评估系统性能的质量指标发生显著变化为止。这种校准相机和VTS数据之间θ旋转参数的方法需要手动标记输入源序列的groundtruth,或者需要人类用户帮助更新θ参数。对于 的多个匹配,数据融合算法继续计算所有当前匹配的演化,直到最终找到唯一匹配。

的多个匹配,数据融合算法继续计算所有当前匹配的演化,直到最终找到唯一匹配。

图20.11 数据融合

图20.12 在完全闭塞的情况下进行数据融合

使视觉跟踪只为前景中的船提供估计,数据融合模块也可以在背景中显示船。

图20.13 非AIS船的数据融合

视觉跟踪器突出了船只的存在。

在图20.9及图20.11~图20.13所展示的图片来自Mardct海事探测、分类和跟踪数据库,其中包含带有地面实况注释的图像和视频。这些视频是以不同的观察角度和天气条件录制的。特别地,对于每一个关于相机类型(静态或移动、EO或IR)和一天中的位置和时间的视频细节,以及用于评估图像分割和带有边界框顶点和标识号的基本事实注释的前景遮罩,以评估跟踪结果。此时,M数据集包含:

(1)在意大利VTS中心录制的EO和IR视频。

(2)在北欧中心拍摄的EO和IR视频。

(3)Argos系统的EO视频监控意大利威尼斯的大运河。

(4)东亚某港口的EO视频。

MarDCT数据库还包含两个示例,其中可视化信息和VTS信息一起记录,以便进行数据融合测试。

数据融合目前很流行,但事实上,它还不是一种成熟的技术。大气环境监测领域还存在许多有待解决的问题,主要包括:

(1)数据缺陷:大气环境监测领域公共数据不多。质量也参差不齐。主要问题包括异常和虚假数据、数据形式的多样性、数据认知和性能的不一致,以及没有标准的数据模型。

(2)数据预处理过程精度不高:大气环境监测数据采集过程中不可避免地存在一些误差。然而,这些客观误差应使用科学方法尽可能减少。

(3)没有统一的数学融合模型:随着数据融合技术的发展,各种数据融合算法应运而生。然而,由于缺乏统一的数学融合模型,没有系统的理论体系和通用的算法结构。面对不同的应用场景,专家们需要做大量的研究和实验来寻找最合适的方法。

虽然已经识别和研究了许多问题,但上述问题都没有得到解决。然而,随着计算机技术的发展,新的理论和方法正在涌现,可以相信,数据融合技术将不断完善,形成一个完整的研究体系,并应用于广泛的实际。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。