分类精度评价体系中,一般将样本中错分的类别数目与样本总数的比率称为“错误率”(error rate)。同理,样本中正确分类的数据与样本总数的比率称为“精度”(accuracy)。如果样本集合的数量为s,错分的类别为e,正确分类的类别为a,则错误率E=e/s,精度为A=a/s,并且A=1-E。分类器在训练集S1的误差称为“训练误差”(training error),在新的数据集S2的误差称为“泛化误差”(generalization error)。如果训练后的模型在训练集精度很高,表现很好,而在新的数据集中表现一般甚至较差,这种现象称为“过拟合”(overfitting);相对地,模型如果在训练集上的表现都不尽如人意,则这种现象称为“欠拟合”(underfitting)。

一般情况下,我们需要对训练后的模型的泛化能力进行评估测试。我们经常将训练模型的数据集叫作“训练集”,测试模型泛化能力的数据集叫作“测试集”。测试集的样本数据要需要与真实样本同分布并且与测试集数据独立,即参与训练的数据不能再参与测试。

机器学习跟深度学习分类中,研究人员经常使用“留出法”作为模型的评估方法。留出法将数据集S按照一定的比例分为两个,一个为训练集Train,另一个为测试集Test。利用随机分层抽样的方法将该数据集进行划分。按照不同模型性能,数据集划分的比例也不相同。常见的做法是将数据集的60%~80%用于训练,剩下的数据用于测试。

除了留出法,交叉验证法也是实验研究中经常用到的检测方法。交叉验证法一般将数据集分成n个大小相同的互斥子数据集,这些数据集独立同分布。一般地,通过n-1次分层抽样可将数据集拆分。在测试模型的时候,依次选择一个作为测试集,剩下的n-1个数据集作为训练集,直至将数据集中的每个子数据集都作为一次测试集用于测试。这样n次遍历后,每次测试集得到的模型精度的平均值就是交叉验证法得到的模型精度的平均值。

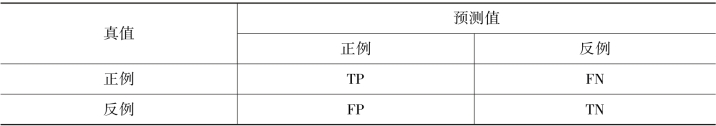

仅仅使用错误率E与精度A是难以满足科研生产任务的需要。科研人员经常使用查准率(percision)、查全率(recall)、F1等。以二分类为例,经过模型的预测结果可分为真正例(True Positive,TP)、假正例(False Positive,FP)、真反例(True Negative,TN)、假反例(False Negative,FN)(表10-2)。

表10-2 模型的预测结果(https://www.xing528.com)

查准率P、查全率R以及F1的定义如下:

此外,Kappa系数、Fβ、ROC、AUC等也是分析结果常用的指数,这里不再一一赘述。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。