为了对评价方法进行优劣比较,本书并没有选用传统的赋权方法,而是选用了基于贝叶斯正则化BP神经网络赋权方法。因为传统的赋权方法大多不可避免地会在计算过程中丢失部分信息,评估结果难以令人满意。而人工神经网络可以通过网络学习达到与其期望输出相符的结果。

所谓正则化,是指为了提高神经网络的推广能力而限制网络权值的规模。因为较小的权值可以使神经网络的输出曲线具有一定的光滑度,以避免过分复杂的曲线对训练数据过度拟合,从而提高神经网络的推广能力。而贝叶斯正则化是指用贝叶斯方法估计正则化参数。[4]

(一)贝叶斯理论

贝叶斯理论把分布参数θ作为随机变量,在获得样本之前,对θ的认识成为先验经验,采用先验分布;获得样本后,样本中又包含了θ新的信息,采用似然函数;通过贝叶斯公式将先验分布与似然函数结合,最终得到θ的后验分布,从而不断更新对θ的认识,这也是贝叶斯理论的精髓所在。

贝叶斯正则化的BP神经网络算法的基本思想是:给定一组训练样本![]() ,神经网络学习的目的是寻找能有效逼近改组样本的函数f,使误差函数最小化,一般情况下,神经网络的训练误差函数采用均方误差函数:

,神经网络学习的目的是寻找能有效逼近改组样本的函数f,使误差函数最小化,一般情况下,神经网络的训练误差函数采用均方误差函数:

这里n为样本数,ti为期望输出值,ai=f(pi)为网络的实际输出值。为了提高泛化能力,可以在目标函数里加上网络权值平均的算术平均值,即目标函数变为:

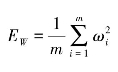

其中, 为网络权重的平方和;ωi是神经网络连接权值;m为神经网络连接权的个数;α、β是目标函数的参数。贝叶斯正则化方法可以在网络训练过程中自适应地调整参数α、β的大小,在保证网络误差平方和最小的前提下,能够有效控制网络的复杂度,从而显著地提高神经网络的泛化能力。

为网络权重的平方和;ωi是神经网络连接权值;m为神经网络连接权的个数;α、β是目标函数的参数。贝叶斯正则化方法可以在网络训练过程中自适应地调整参数α、β的大小,在保证网络误差平方和最小的前提下,能够有效控制网络的复杂度,从而显著地提高神经网络的泛化能力。

若α<β,则训练算法倾向于使学习集网络响应的误差减小,容易使网络出现过拟合现象;若α>β,则训练强调权值的减小,自动缩小了网络规模,使网络的输出更加平滑,可有效增强网络的泛化性能,但容易导致网络欠拟合。

(二)贝叶斯正则化算法

用常规的正则化算法很难确定α和β,贝叶斯正则化算法恰好可以在网络训练中自适应调节α和β,使其达到最优解。将网络权值视为随机向量,根据贝叶斯规则给定学习集后权值的后验概率密度函数如式(4-17)所示。

式中,D为学习集数据;M为采用的神经网络模型;p(D|α,β,M)为总体概率密度函数;p(w|α,M)为权值向量的先验概率密度函数;p(D|w,β,M)为权值给定时输出的概率密度函数。

假设样本数据中存在噪声和权向量服从正态分布,则有:(https://www.xing528.com)

其中, 。由于标准化因子p(D|α,β,M)与权值向量w无关,本书选用的公式为:

。由于标准化因子p(D|α,β,M)与权值向量w无关,本书选用的公式为:

其中, 。

。

最优的权值向量应具有最大后验概率p(w|D,α,β,M),最大的后验概率在Z(α,β)一定的情况下等价于最小正则化目标函数F,F最小点w0处α和β的优化解为:

其中,γ为学习集训练确定的网络参数的有效个数。

(三)贝叶斯正则化神经网络权重训练步骤

第一步,确定网络结构,初始化超参数α和β,一般设定为α=0和β=1。根据先验分布对网络参数赋予初始值。

第二步,用BP算法训练网络,使总误差F=βED+αEW达到最小。

第三步,利用高斯-牛顿逼近法求Hessian阵∇2F≈2βJTJ+2αIm,并计算有效参数个数γ。

第四步,计算超参数α和β新的估计值。

第五步,循环执行第二步、第三步、第四步。

贝叶斯正则化神经网络法是个迭代过程,每个迭代过程中总误差函数随着超参数的变化而变化,最小值点也在变化,网络的参数也在不断修正,最终达到总误差函数在迭代过程中没有较大改变,结果更加收敛。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。