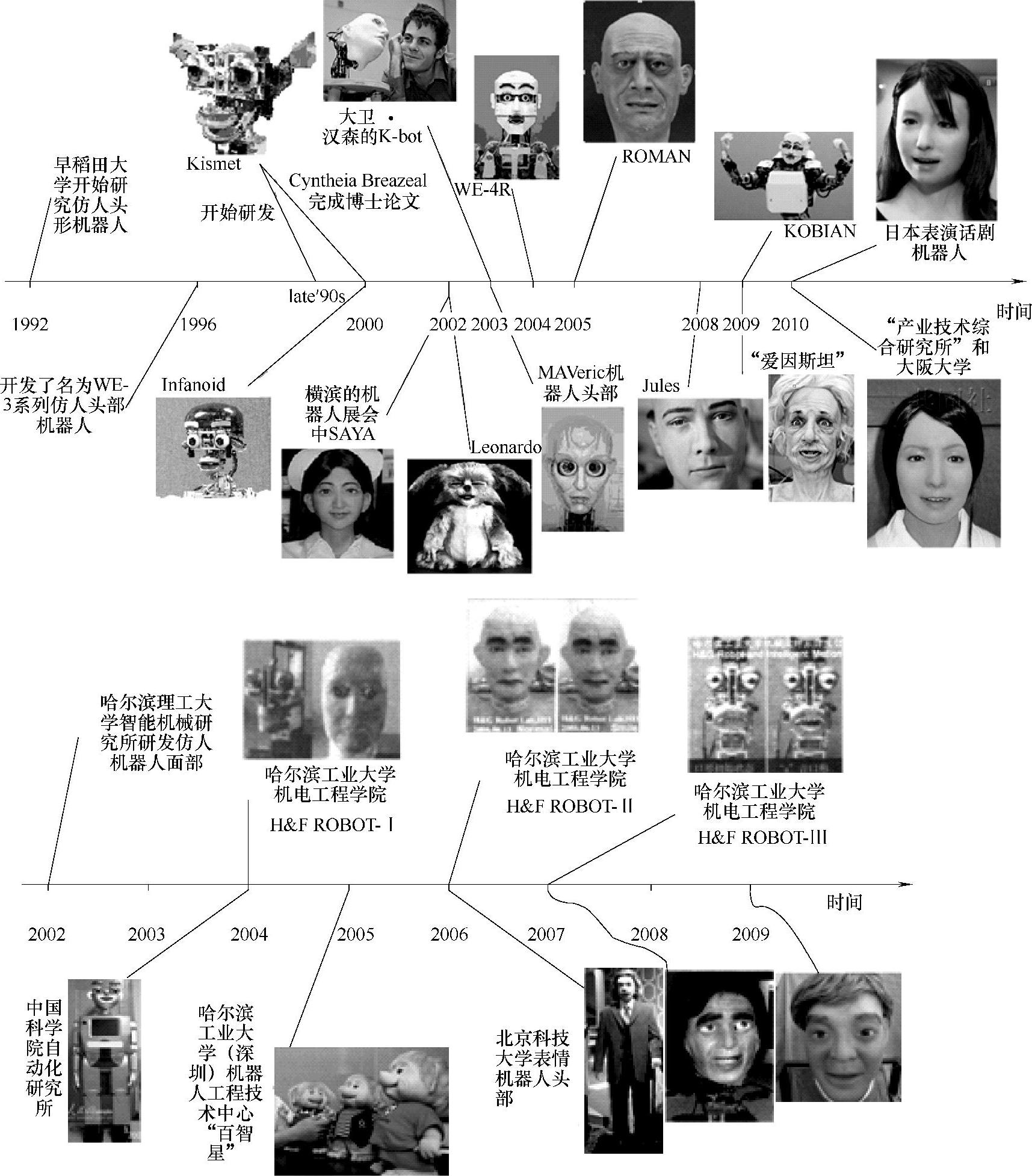

世界各国的实验室都在这一领域展开研究,如日内瓦大学Klaus Scherer领导的情感研究实验室、布鲁塞尔自由大学D.Canamero领导的情感机器人研究小组及英国伯明翰大学A.Sloman领导的Cognition and Affect Project(认知与情感研究项目)等。我国对这一领域的研究始于20世纪90年代,主要针对人工情感单元理论与技术实现开展研究,如多功能感知机器人,主要包括表情识别、人脸识别、人脸检测与跟踪、手语识别、表情合成、唇读等基于人工情感的机器人控制体系结构的研究。图1-3所示为对国内外具有情感的物理机器人的研究之路的梳理。

图1-3 国内外表情机器人的发展过程

从图1-3可以发现,日本、美国的大学和研究所的研究开展较早,且多集中在早稻田大学和麻省理工大学,发展较快;德国与英国近期也开始进行相关研究;我国自2002年开始发展对表情机器人的研究。目前国内比较先进的机器人有哈尔滨工业大学研制的“百智星”幼教机器人,中国科学院自动化研究所研制的“童童”机器人,北京科技大学研制的情感机器人头部。下面对几种情感机器人进行简单介绍。

日本早稻田大学理工部高西研究室于1992年开始研究仿人头部机器人,从1996年起开始开发名为WE系列的仿人头部机器人,至今已研制出了四个版本的WE系列仿人头部机器人,并以多种传感器作为感觉器官。例如,WE-4型机器人在眼球中安装彩色CCD(Charge Cou-pled Device,电耦合元件)摄像头采集视觉信息并进行颜色识别;在耳部安装微型麦克风,采集声音信息;在机器人的面颊、前额、和头部两侧安装力敏电阻作为触觉器官,识别不同触觉行为(如推、打和抚摸);采用热敏电阻传感器感受温度;用4个半导体气体传感器作为嗅觉器官,识别酒精、氨水和香烟的气味,可以说WE-4是目前感官器官最为齐全的机器人。

美国麻省理工学院人工智能实验室的计算机专家辛西娅·布雷齐尔(Cynthia Breazeal)从婴儿与看护者之间的交流方式中得到启发,开发了一个名为“Kismet”的婴儿机器人。目前它只有头部与计算机相连,面部特征具有15个自由度,分布于眉毛、耳朵、眼球、眼睑、嘴唇等部位,每只眼睛装有一个5.6mm焦距的彩色CCD摄像机,耳部装有微型传声器,使它具有视觉和听觉。“Kismet”具有与人类婴儿相似的行为方式和能力,如模仿父母与孩子之间表达情感的反馈方式,婴儿向父母表达需求和愿望的方式,以及婴儿自我学习与人和环境交流的方式等。

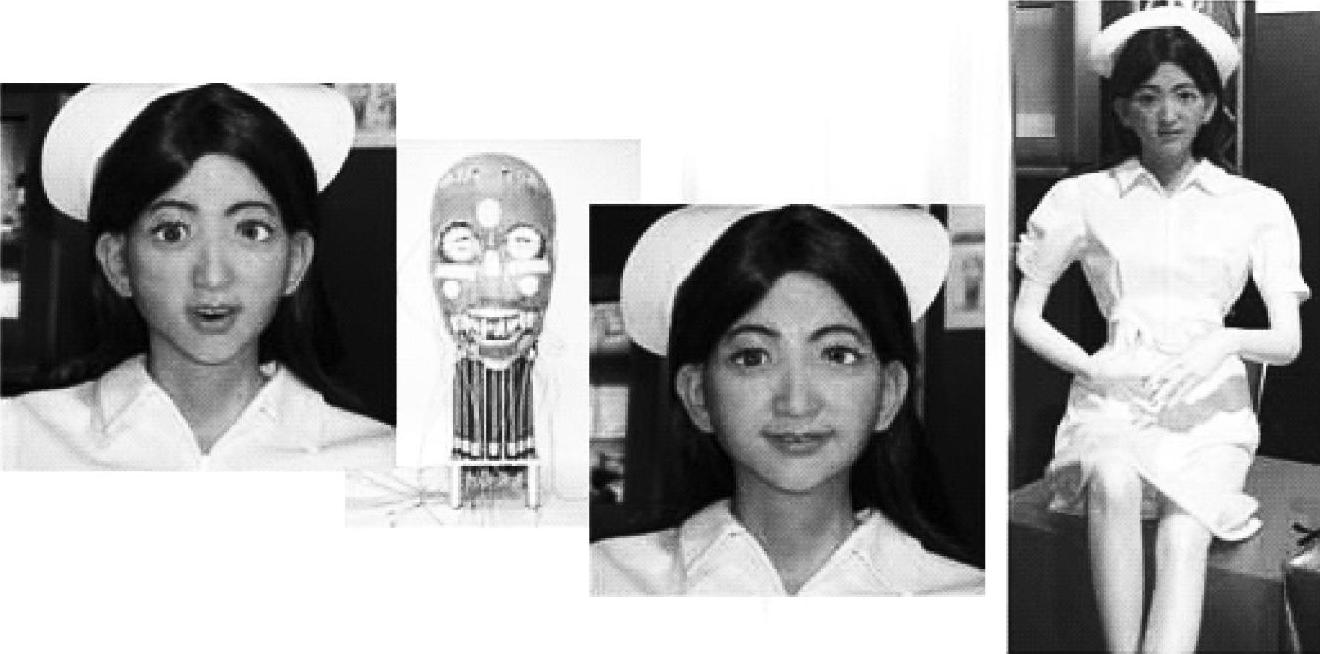

2002年在日本横滨举行的机器人展会上,东京理科大学的展台上坐着一个身穿白色连衣裙的“姑娘”,长头发、大眼睛。她就是小林宽司教授研制的仿人机器人SAYA(见图1-4),它能扫描注视者的表情,比较其眼、口、鼻、眉的距离,与记忆库中自然表情的面孔对比,识别出该表情所表达的某种情绪,然后由人工肌肉带动并协调18个面部关键点的运动,展示出相应的喜悦、生气、惊讶等逼真表情。这项计划通过优化机器人的表情,来改善人与机器人的关系。人们尤其是老人不接受机器人,机器人就无法为人类服务,因此,我们需要尝试制造能被老人接受的机器人。SAYA目前还不能行动,只是面部机器人,但她面部五官齐全,有皮肤,与真人十分接近。小林宽司教授的下一个目标是让机器人能够开口说话,当前他已开始着手研发有舌头的说话机器人。相信在不久的将来,感情丰富、行动自如的SAYA一定会走到我们面前。

图1-4 东京理科大学的SAYA机器人(https://www.xing528.com)

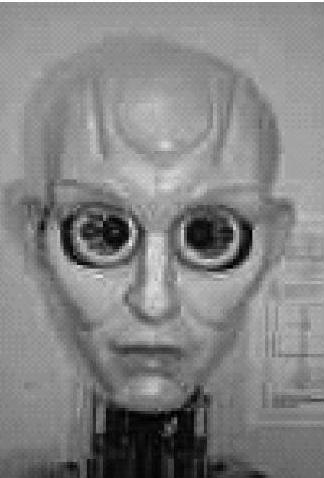

另外,东京理科大学还研制了机器人AH I(见图1-5)。其外观上是一个女性的头部,装有假牙、硅橡胶皮肤和假发,形象与人类十分接近。AHI由微型气压柔性驱动器驱动面部18个控制点,可以实现人的喜、怒、厌、悲、恐、惊六种基本表情。塑料的眼球后面装有18mm的CCD微型摄像机,用来采集目标面部图像数据,并由大脑的分层神经网络进行面部表情的实时识别,可以识别人的喜、怒、厌、悲、恐、惊六种基本表情。SAYA和AH I两个机器人都采用基于Ekman和Friesen的分析方法,把六种基本表情分解成14个面部运动单元(AU)的组合,通过对面部18个特征点的控制,实现各运动单元,进而组合出各种表情。

由RIKEN脑科学学会实验室、南加利福尼亚大学计算机学习及电机控制实验室以及SARCOS公司合作开发的名为MAVeric的机器人头部(见图1-6),具有7个自由度。其运动是通过在计算机上编写软件程序来实时控制的。MAVeric可以在发出声音的同时伴随产生嘴部运动,该运动通过计算机传输的指令经RS232串行接口输送到一个串行控制电路板,由VB程序编写的活动窗口控制。

图1-5 东京理科大学的AH I机器人

图1-6 MAV eric机器人头部

以上是几个具有代表性的(仿人)头部机器人研究成果。此外,还有美国德州大学达拉斯分校的博士生大卫·汉森发明的“K-bot”头部机器人,日本京都通讯研究室开发的婴儿机器人“Infanoid”,美国卡内基·梅隆大学开发的“Beardsley”,日本早稻田大学开发的“ISHA”、中国香港模型屋公司制造的头部机器人,美国加州大学研制的机器人头部,德国帕德伯恩大学C实验室的Mexi,美国卡内基·梅隆大学的4目头部机器人,MarkMedonis的MAXWELL等等。日本本田公司的“阿西莫(Asimo)”,NEC公司开发的伴侣机器人“PaP-eRo”,Sony公司的“SKR24X”机器人,日本仿人机器人财团的“小IF”,以及世嘉玩具公司的人形机器人玩具“世博(C2BOT)”等,也具有一定的表情识别和通过表情表达情感的功能。

我国对这一领域的研究始于20世纪90年代,大部分研究工作是针对人工情感单元理论与技术实现的。中国工程院院士蔡鹤皋教授也曾在1996年研制出一款具有讲演技能的仿人演讲机器人,该机器人头部兼具眼球运动、嘴巴讲话带动面部肌肉运动等机能。哈尔滨工业大学类人与类人猿机器人研究室于2004年在国内首次研制成功具有八种基本面部表情(包括自然表情、严肃、高兴、微笑、悲伤、吃惊、恐惧、生气)的仿人头像机器人H&F ROBOT-I,该机器人具有14个自由度,其中机器人头部具有7个自由度,实现了对人体头部器官运动和基本面部表情的模仿。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。