人们在搜索图像时,通常希望搜索到场景语义相似的图像。而图像场景语义的理解通常包含了三个层次的内容:检测并识别图像中包含的目标(比如人、动物、物品等),判定目标的属性(比如衣服的颜色、物体的大小等),分析目标与目标之间的空间关系或动作(比如人站在栏杆前面、正在奔跑的小狗等)并加以推理或联想,比如根据“食物、刀叉、盘子”等相互之间具有关联性的目标,推理出“厨房、食堂”,甚至联想出“聚餐”等场景,或者根据的“人、火车轨道”可以推理出“人正在等车”等。

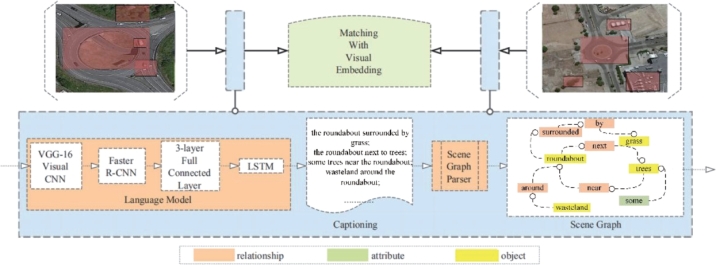

图像描述生成将对图像视觉内容的描述由词或标注扩展到短语再到句子,构建了包含对象、对象属性及对象之间空间关系的图像细节语义信息表达模型,有利于增强对图像场景语义的理解,有效改善图像检索的性能。Wei X.等人(2017)提出一种基于场景图的检索方法,如图8-25所示,将检索任务转变为图像描述生成和图像描述匹配的问题,图像检索过程由图像描述生成、创建场景图、场景图匹配3个步骤组成。具体算法流程描述如下:

图8-25 基于图像描述场景图的检索系统框图[80]

一、图像-描述

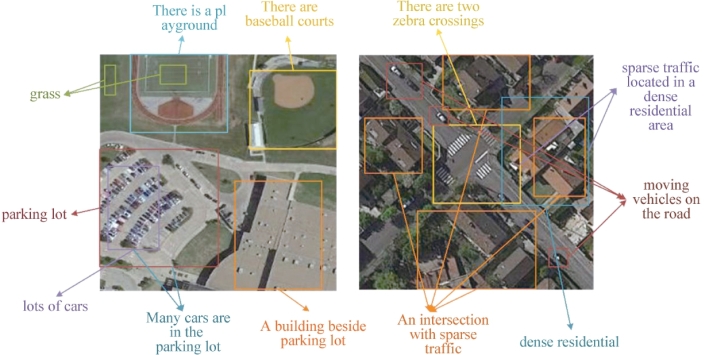

首先,生成图像的稠密描述,即基于区域的描述。具体方法为:首先采用VGG-16网络获得具有3×W×H形状的所有区域的深层特征,并输出特征张量C×W′×H′,其中C=512,W′=[W/16]和H′=[H/16];然后,将输出张量传递到具有Faster R-CNN相同结构的下一层。选择B个兴趣区域并输出三个张量,其中包含有关区域权重的信息(一个长度为B的向量,表示每个兴趣区域的置信权重)、区域坐标即形状B×4的矩阵)和区域特征张量(形状为B×C×X×Y的张量);接下来,采用一个具有3层全连接神经网络的网络处理输出区域特征,并为下一层生成一个维度为B×D (D=4096)的矩阵;最后,采用LSTM语言模型生成图像描述。图8-26给出一个稠密描述生成示例。

图8-26 稠密描述生成示例[80]

二、图像描述-场景图

场景图是一种用于描述场景特定语义信息的规范化数据结构。其中,节点代表对象,边代表对象之间的关系。对于给定的对象类别集合C,属性类别集合A和关系类别集合R,一个场景图可以定义为一个元组G(O,E),其中O={o1,o2,…,on }表示对象集合,E∈O×R×O表示边集合。每个对象都可以表示为oi=(ci,Ai)的形式,其中ci∈C,Ai∈A分别表示对象类别和对象属性。由于场景图仅仅表示了图像中可以被描述的一个场景,为了用场景图描述图像,可以将场景图中每一个对象实例“关联到”图像中一个特定区域。例如,一幅图像可以用候选框集合B来表示,那么一个场景图G(O,E)可以映射为图像中的一个区域γ:O→B,其中o∈O。显然,对于包含复杂场景的图像,相对一大段纯文本描述,从场景图中获取图像的对象-属性-关系等语义信息要容易得多。将图像描述解析为场景图的形式化描述为[82]:

![]()

其中,O(c)表示包含在语句c中的对象集;E(c)表示两个对象之间关系的边集;K(c)表示描述对象的属性集。

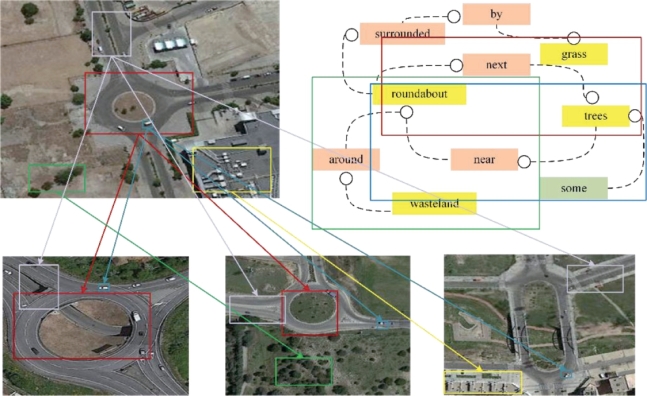

图8-27给出一幅原始图像及其生成的场景图。

图8-27 查询图像及其生成的场景图[80](查询图像。右上方:用于查询图像的场景图的一部分。示例输出相关图像,其中包含非常相似的视觉概念,如“环岛”“绿植”“道路”“建筑”和“汽车”来查询图像)

三、场景图匹配

场景图匹配是通过视觉概念嵌入计算场景图之间的相似度,并以此对相似图像进行排序。视觉嵌入可以用来衡量场景图所包含的视觉概念之间的语义距离。(https://www.xing528.com)

基于视觉概念嵌入的场景图匹配可被视为元组匹配的问题,它聚集了两个场景图之间所有元组对之间的相似性。形式上,定义一个函数T,从场景图中获得逻辑组元组[82]:

![]()

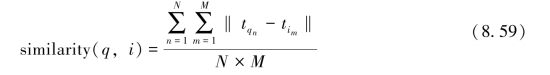

用于图像检索时,对于给定的查询图像q和一组候选图像I={i1,i2,...im},检索的目标是根据候选图像与查询图像q的场景图之间所有元组之间的相似性对候选图像进行排序。首先通过人工生成的图像描述训练Word2vec模型,从而将元组的描述转换为单词向量,并通过计算元组之间的距离来度量它们之间的语义相似性。这样就将图像的相似性度量转换为元组匹配,公式如下:

其中,N是集合T(G(q))的元素个数;M是集合T(G(i))的元素个数;tqn∈T(G(q));tim∈T(G(i))。

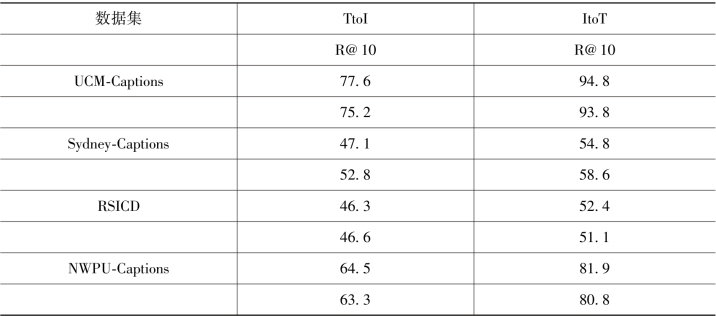

表8-6给出基于场景图的遥感图像检索为性能评价结果。同样以UCM-Captions、Sydney-Captions、RSICD和NWPU-Captions为数据集,采用Inception V3网络提取遥感图像的深度视觉特征,用于提取文本语义特征的递归神经网络为GRU。选取R@K评价检索性能,R@K定义为top K检索结果中正确项所占的百分比(这里K设置为10)。表中,“TtoI”表示从描述检索图像,“ItoT”则表示从图像检索描述。

表8-6 基于图像描述场景图的遥感图像检索结果(R@10:%)

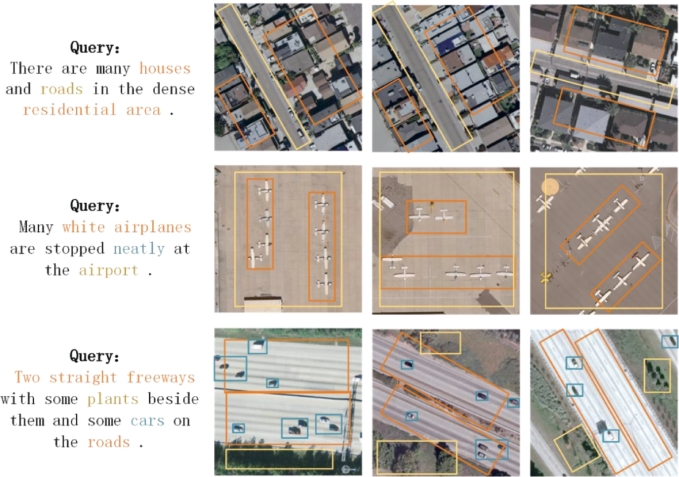

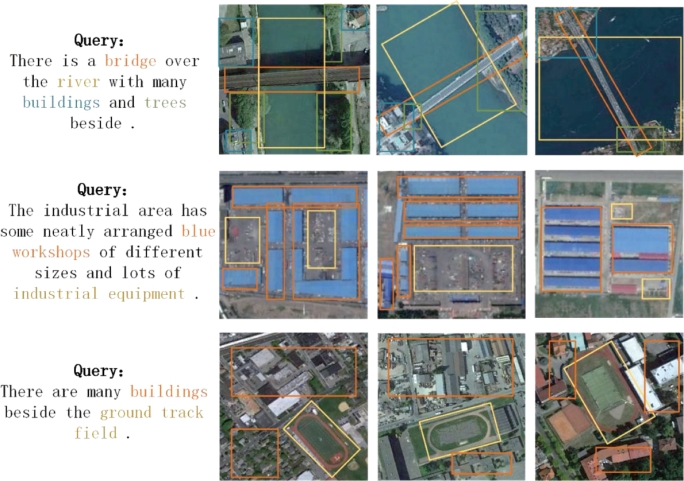

图8-28 基于图像描述场景图的遥感图像检索结果(以UCM-Captions数据集为例)

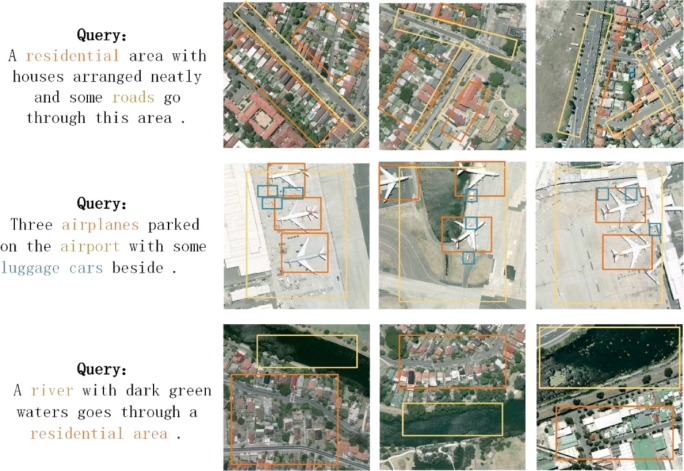

图8-29 基于图像描述场景图的遥感图像检索结果(以Sydney-Captions数据集为例)

图8-30 基于图像描述场景图的遥感图像检索结果(以RSICD数据集为例)

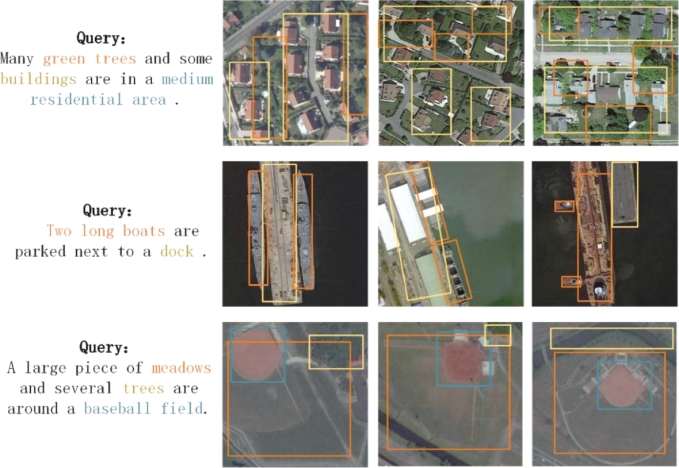

图8-31 基于图像描述场景图的遥感图像检索结果(以NWPU-Captions数据集为例)

图8-28~图8-31给出4组基于场景图的遥感图像检索结果。分别以UCM-Captions、Sydney-Captions、RSICD和NWPU-Captions数据集为例,提交的查询条件为图像描述,检索结果为遥感图像。生成的图像描述中,用不同颜色表示不同的语义类别,在检索的图像中用相同颜色的方框标出对应的场景。检索结果表明,基于场景图的方法可以实现用描述语句检索出匹配的遥感场景。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。