一、基础知识

人工神经网络(Artificial Neural Networks,ANN)是近几年发展起来的交叉学科,它涉及生物、电子、计算机、数学、物理等学科。由于在复杂非线性系统中有较高的建模能力及对数据的良好拟合能力,已在许多工程领域得到广泛应用(张立明,1993;李孝安等,1994;李人厚,1999;徐丽娜,1999;刑文训,谢金星,1999)。

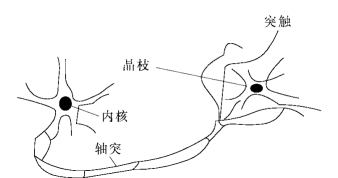

人工神经网络模型基于生物学中神经网络的基本原理建立。图1-4-4是生物学中神经网络简图。

图1-4-4 生物学中神经网络简图

神经网络是大脑的重要组成成分,由相互关联的神经元组成。每一个神经元由内核、轴突和多个晶枝组成。晶枝形成一个非常精密的“毛刷”,环绕在内核周围。轴突可以想像为一根又长又细的管道,其终点分为众多细小分支,将内核的信息传递给其他内核的晶枝。这些细小分支的头,即那些又长又细管道的终点,称为突触,它们的主要功能是接触其他内核的晶枝。

一个神经元通过晶枝接收到一定的信息后,便对这些信息进行处理,再通过它所控制的突触传送给其他的神经元。神经元可分为“抑制”性的或“兴奋”性的两种。当一个神经元的晶枝接收的兴奋信息累积超出某一固定值(阈值)时,这个神经元被激活,并传递出一个信息给其他神经元,这种传递信息的神经元称为“兴奋”性的。神经元虽然接收到其他神经元传递的信息,但没有向外传递信息,此时,称这个神经元为“抑制”性的。

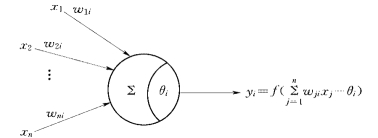

图1-4-5 形式神经元模型

简单模拟上面原理的人工神经网络是形式神经元模型(图1-4-5),该神经元通过晶枝接收到n个信息。

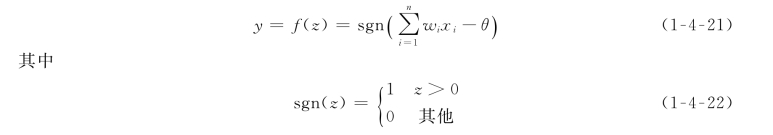

在图1-4-5中,w i为连接权,表示神经元对第i个晶枝接收到信息的感知能力。函数f(z)称为输出函数或激活函数。一种常见的阈值型激活函数可以定义为

式中:θ为阈值。

当w i为固定值时,对给定的一组输入(x 1,x 2,…,x n),由式(1-4-21)计算得到输出值。对给定的输入,为使式(1-4-21)的计算输出同实际值吻合,需确定合理的参数w i。人工神经网络方法的主要任务就是建立模型和确定w i的值。

二、神经网络的学习与回忆

神经网络通过学习和回忆,建立输入变量与输出变量之间的非线性关系。

1.神经网络的学习

神经网络的最重要特征之一就是学习(也称为训练)。通过学习,调整参数w i,尽可能使式(1-4-21)的计算输出同实际值吻合。

给定p组学习样本(x 1,x 2,…,x n;T 1,T 2,…,T m)k(k=1,2,…,p),其中(T 1,T 2,…,T m)k(k=1,2,…,p)为相应的p个期望输出序列。在对网络进行训练前,先将连接权w i赋初值,然后将第一组学习样本中的输入序列(x 1,x 2,…,x n)1,以及相应的期望输出序列(T 1,T 2,…,T m)1输入网络,计算出网络输出(y 1,y 2,…,y m)1。随后将余下的p-1组学习样本依次输入神经网络,计算相应的网络输出。

定义网络输出与期望输出的误差为

通过训练,调整网络内部连接权w i,使网络输出与期望输出的误差达到最小。2.神经网络的回忆

神经网络的训练完成后,即可进行回忆操作,即对网络输入向量X,使网络给出系统真实输出序列Y的近似值序列Y′。

从数学角度来看,神经网络是一组输入单元到输出单元的映射。若网络输入层有n个单元,输出层有m个单元,即有如下映射

![]()

对于样本集合输入{x i}和输出{y j},可以认为存在某一映射G,使得

![]()

利用神经网络求解问题的实质即是求得一个映射F,使得在某种意义下F是G的最佳逼近。1989年,Robert Hecht Nielson证明了对于任何在闭区间内的一个连续函数都可以用一个隐层来逼近,因而一个3层的网络可以完成任意的n维到m维的映射。

三、BP网络

1.BP网络的结构

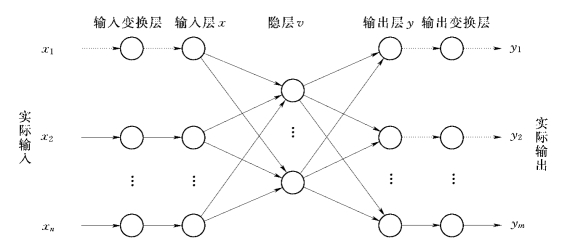

神经网络按连接结构分为两大类:分层结构与相互连接结构。分层结构网络有明显的层次,信息的流向由输入层到输出层,即前向网络。相互连接结构网络,没有明显的层次,任意两个处理单元之间都是可达的,具有输出到输入的反馈连接,故又称为反馈网络。适合作反分析用途的均为前向网络。前向网络一般具有输入层、隐层和输出层。输入层没有处理功能,只能接收输入信号和分配输入信号;输出层则起着产生输出信号的作用;中间层又称为隐层,具有处理功能,但不直接与外部环境打交道。BP网络是前向网络模型中使用最广泛的一类。图1-4-6为常规的3层BP网络结构,x k表示输入层的输入,v j表示隐含层的输出,y i表示输出层的输出,w jk表示从输入层单元到隐含层单元的连接权,w ij表示从隐含层单元到输出层单元的连接权,输入层单元、隐含层单元和输出层单

图1-4-6 BP网络结构图

元的数量分别为n、l、m,其激活函数常采用式(1-4-26)所示的S型出数表示。

![]() (https://www.xing528.com)

(https://www.xing528.com)

2.BP网络的学习算法

BP网络的学习过程由正向传播和反向传播组成。在正向传播中,输入信息从输入层经过隐含层作用函数的作用传向输出层,每一层神经元的状态只影响到下一个神经元的状态。如果输出信号与期望输出信号有差别,则误差信号沿着原来的线路返回,通过修改神经网络连接权重,使得输出信号误差最小,即网络输出值与期望输出值之间误差最小。隐含单元与外界没有直接联系,但隐含单元的结构和状态影响输入输出之间的关系。

设有p组学习样本

在网络学习的过程中,不断调整网络中权值与阈值,使误差函数E趋于最小。E相当于定义在权重w jk构成的高维空间上的一个函数,求E值最小值的过程也就是求一个无约束的优化问题,可以用非线性规划中的最速下降法,使权重向量w jk沿着误差函数E负梯度方向改变。

式中:r为迭代次数;η为学习率。

由于最速下降的特征只在w jk(n)的局部,所以η原则上应取得尽量小。但如果η太小,对w jk的调整量就会很小,导致学习时间增加。为使η的选取较容易一些,同时加快反传算法的收敛性,可增加一惯性项,用n步之前的修正量对第n步的修正进行综合。修正量表示为

式中:η、α分别为学习率和动量因子,一般取值范围为(0,1)。η大,收敛快,但不稳定,可能出现振荡;η小,收敛缓慢,需花费较长的学习时间。α的作用与η正好相反。

根据式(1-4-39),式(1-4-38)可改写为

由式(1-4-29)~式(1-4-34)、式(1-4-40)~式(1-4-42)、式(1-4-48)、式(1-4-51)、式(1-4-52)构成了BP网络完整的算法。

3.BP网络的训练

网络的训练过程如下:

(1)输入、输出样本的归一化,即将样本的输入输出参数转化至区间[0,1]。

(2)用[-1,1]之间产生的随机数给权值赋初值。

(3)将样本中的自变量赋予输入层相应的结点,依权值和激励函数的作用在输出结点算得网络的输出值。

(4)计算网络输出与期望值之间的均方差。

(5)从输出层开始,将误差反向传播至第一层,按梯度法修正权值,转到步骤(3)重新计算。

重复上述步骤,直至误差函数满足给定误差ε为止,即

训练结束后,即可采用训练好的网络进行预测。

四、算例说明——岩体初始应力场反演

对于如图1-4-1所示的岩体,可利用BP神经网络建立应力与荷载多元输入与输出的非线性映射关系。映射关系一旦建立,即可依据实测应力得到边界荷载,然后利用边界荷载进行一次常规有限单元计算,即可得到岩体初始应力场。

利用BP网络反演岩体初始应力场的具体步骤如下:

(1)组织训练样本。选取不同边界荷载组合,对每一组合进行常规有限单元法计算,得到实测点处的应力值。以该应力值作为网络输入,边界荷载作为网络输出,每组边界荷载及相应应力值对应一个样本。

(2)网络学习。用训练样本集训练网络,直至收敛。

(3)将实测应力值输入训练好的网络,网络输出即为反演出的边界实际荷载。

(4)根据岩体边界实际荷载,再通过常规有限单元法计算,即可得到岩体初始应力场。

仍采用本章第四节的算例,但将边界荷载稍加调整。调整后的边坡在容重Δ=0.027MN/m3、两组面力U=3MPa和V=4MPa(图1-4-3)共同作用下,边坡部分区域屈服。用有限单元法进行弹粘塑性计算,计算出应力场后,将此应力场视为真实初始应力场。取坡体中不同位置的5个点作为实际测点,然后依据这几个实测点的应力值,通过BP神经网络获得反演初始应力场。通过这两个初始应力场的比较,可对本节介绍方法的有效性做出初步判断。

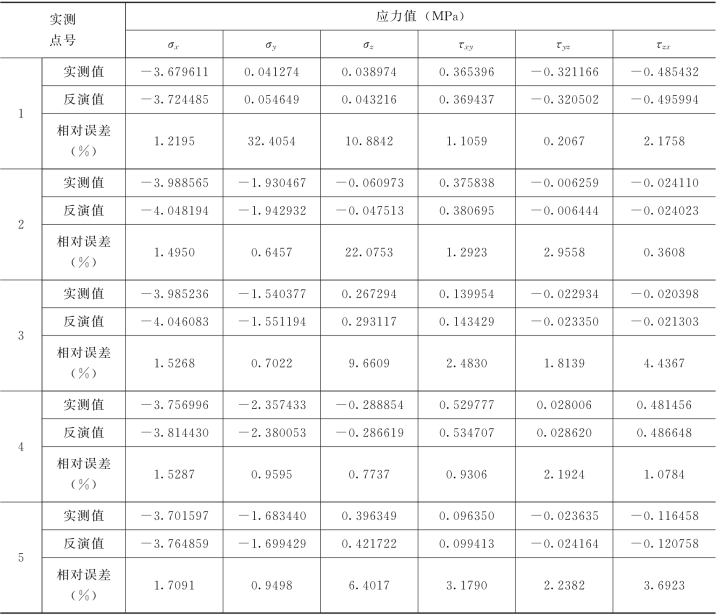

通过有限单元法计算,生成样本集(28个样本)。取误差ε=0.5,用样本集对BP网络进行训练。网络经过229561次学习后,达到要求。以实测应力值输入BP网络,网络输出实际边界荷载为:Δ′=0.026MN/m3、U′=3.03MPa、V′=4.06MPa。根据反演的实际边界荷载,再进行一次有限单元法计算,得到反演的初始应力场。反演结果如表1-4-4所示,总体平均相对误差为4%。

表1-4-4 初始应力测值与反演值对比

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。